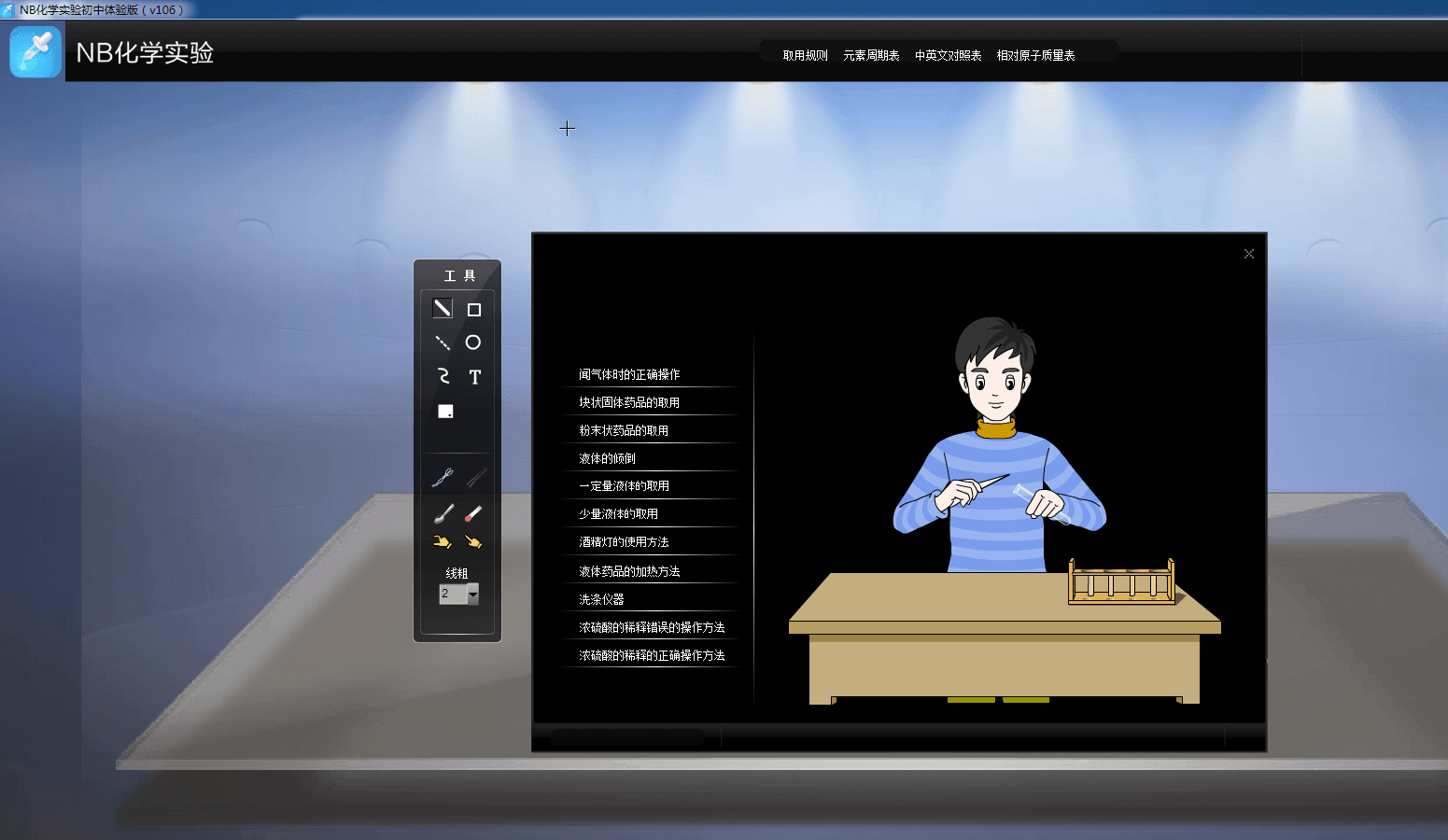

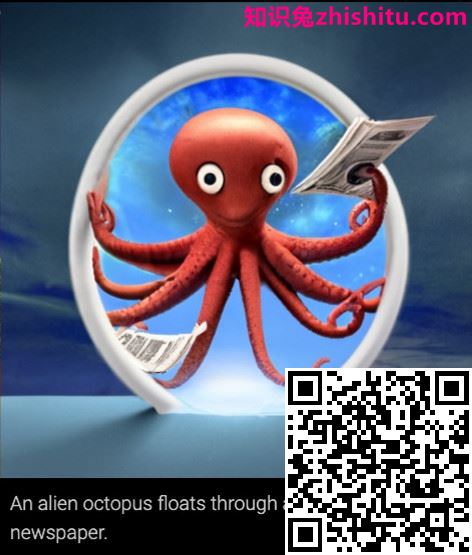

所有这些图像都是由谷歌最新的文本到图像人工智能生成的

迄今为止,该领域的领导者一直是 DALL-E,这是一个由商业 AI 实验室 OpenAI 创建的程序(并在 4 月刚刚更新)。不过,昨天,谷歌宣布了自己对Imagen 类型的看法,它刚刚在输出质量上取代了 DALL-E。

了解这些模型的惊人功能的最佳方法是简单地查看它们可以生成的一些图像。上面有一些 Imagen 生成的,下面还有更多

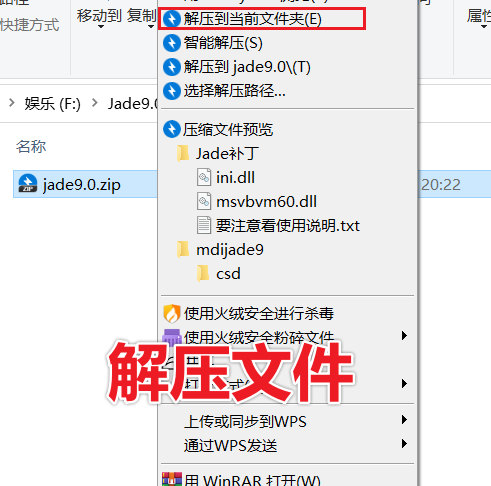

在每种情况下,图像底部的文本都是输入程序的提示,上图是输出。只是要强调:这就是它所需要的。你输入你想看到的内容,程序就会生成它。太棒了,对吧?

但是,尽管这些照片的连贯性和准确性无可否认令人印象深刻,但它们也应该用少许盐来拍摄。当像 Google Brain 这样的研究团队发布新的 AI 模型时,他们往往会挑选出最好的结果。因此,虽然这些图片看起来都很完美,但它们可能并不代表图像系统的平均输出。

通常,由文本到图像模型生成的图像看起来未完成、或比较模糊——我们在 OpenAI 的 DALL-E 程序生成的图片中看到了这些问题。

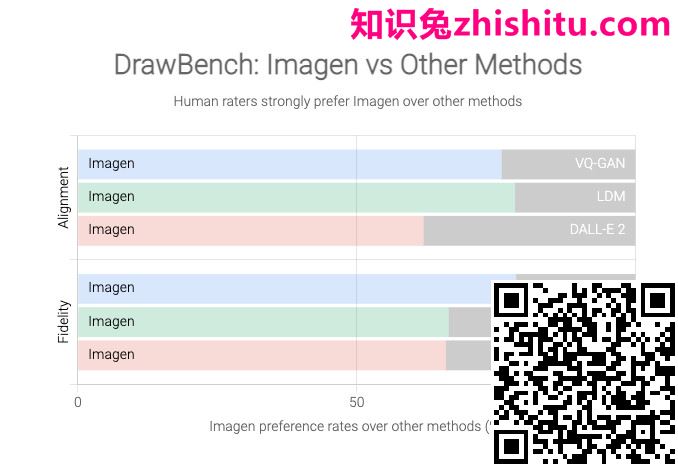

不过,谷歌声称 Imagen 生成的图像始终比 DALL-E 2 更好,这是基于它为这个名为 DrawBench 的项目创建的新基准。

DrawBench 并不是一个特别复杂的指标:它本质上是一个包含大约 200 个文本提示的列表,Google 的团队将这些提示输入 Imagen 和其他文本到图像生成器,然后知识兔由人工评估员判断每个程序的输出。如下图所示,谷歌发现人类通常更喜欢 Imagen 的输出而不是竞争对手的输出。

不过,我们自己很难判断这一点,因为谷歌并没有向公众分享 Imagen 模型。这也是有充分理由的。尽管文本到图像的模型确实具有巨大的创造潜力,但它们也有一系列令人不安的应用。想象一下,一个系统可以生成几乎任何你喜欢的图像,例如用于假新闻、恶作剧或骚扰。正如谷歌所指出的,这些系统也编码了社会偏见,它们的输出通常是种族主义、性别歧视或以其他一些创造性的方式有毒。

这在很大程度上是由于这些系统的编程方式。从本质上讲,他们接受了大量数据的训练(在这种情况下:大量的图像和字幕对),他们研究这些数据的模式并学习复制。但是这些模型需要大量的数据,大多数研究人员——即使知识兔是那些为像谷歌这样资金雄厚的科技巨头工作的研究人员——都认为全面过滤这些输入过于繁琐。因此,他们从网络上抓取了大量数据,因此他们的模型会摄取(并学会复制)您期望在网上找到的所有可恶的胆汁。

正如 Google 的研究人员在他们的论文中总结的那样:“[T] 文本到图像模型的大规模数据需求 […] 导致研究人员严重依赖大型的、大部分未经管理的网络抓取数据集 [. ..] 数据集审计显示,这些数据集往往反映社会刻板印象、压迫性观点以及与边缘化身份群体的贬损或其他有害关联。”

换句话说,计算机科学家那句老生常谈的格言仍然适用于人工智能的疯狂世界:垃圾进,垃圾出。

谷歌没有详细介绍 Imagen 生成的令人不安的内容,但指出该模型“编码了几种社会偏见和刻板印象,知识兔包括对生成肤色较浅的人的图像的总体偏见以及描绘不同图像的趋势。符合西方性别刻板印象的职业。”

这也是研究人员在评估 DALL-E 时发现的。例如,知识兔让 DALL-E 生成“空姐”的图像,几乎所有受试者都是女性。索要“CEO”的照片,然后知识兔,惊喜,惊喜,你得到了一群白人。

出于这个原因,OpenAI 也决定不公开发布 DALL-E,但该公司确实允许选择 beta 测试人员。它还过滤某些文本输入,试图阻止该模型被用于生成种族主义、暴力或色情图像。这些措施在某种程度上限制了这项技术的潜在有害应用,但人工智能的历史告诉我们,这种文本到图像的模型几乎肯定会在未来的某个时候公开,更广泛的访问会带来所有令人不安的影响.

谷歌自己的结论是,Imagen“目前不适合公众使用”,该公司表示计划开发一种新方法来衡量“未来工作中的社会和文化偏见”并测试未来的迭代。不过,就目前而言,我们必须对该公司乐观的图片选择感到满意——浣熊皇室和仙人掌戴着太阳镜。不过,这只是冰山一角。如果知识兔 Imagen 想要尝试生成技术研究的意外后果,那么这就是冰山。